Automatic Prompt Engineer (APE)

Fonte immagine: Zhou et al., (2022) (opens in a new tab)

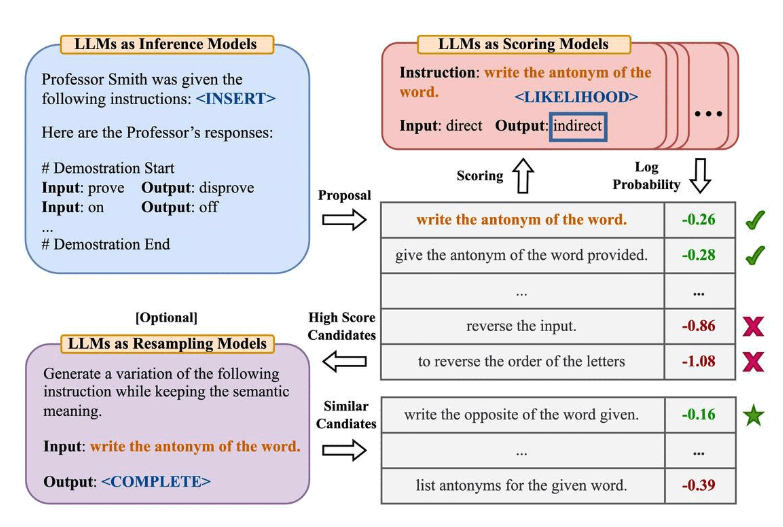

Zhou et al., (2022) (opens in a new tab) propone automatic prompt engineer (APE), un framework per la generazione e la selezione automatica delle istruzioni. Il problema della generazione delle istruzioni viene inquadrato come sintesi del linguaggio naturale e affrontato come un problema di ottimizzazione black-box che utilizza gli LLM per generare e ricercare le soluzioni candidate.

La prima fase coinvolge un modello linguistico di grandi dimensioni (come un modello di inferenza) a cui vengono fornite dimostrazioni in uscita per generare istruzioni candidate ad un certo compito. Queste soluzioni candidate guideranno la procedura di ricerca. Le istruzioni vengono eseguite utilizzando un modello di destinazione e poi l'istruzione più appropriata viene selezionata in base ai punteggi di valutazione calcolati.

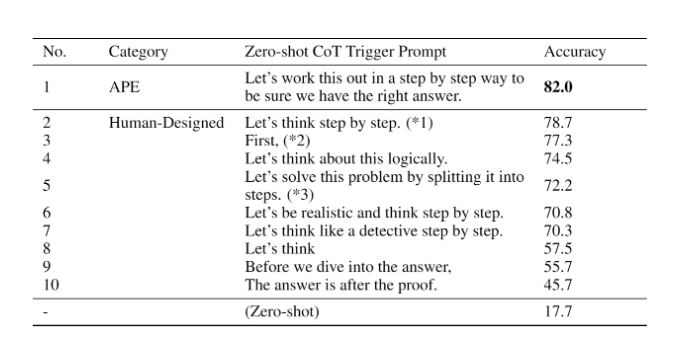

APE scopre un prompt zero-shot CoT migliore del prompt "Pensiamo passo dopo passo" progettato manualmente (Kojima et al., 2022 (opens in a new tab)).

Il prompt "Lavoriamo passo dopo passo per essere sicuri di avere la risposta giusta" suscita un ragionamento a catena e migliora le prestazioni nei benchmark MultiArith e GSM8K:

Fonte immagine: Zhou et al., (2022) (opens in a new tab)

Questa ricerca tratta un argomento importante legato al prompt engineering, ovvero l'idea di ottimizzare automaticamente i prompt. Anche se in questa guida non approfondiamo l'argomento, ecco alcuni documenti chiave se siete interessati:

- Prompt-OIRL (opens in a new tab) - propone di utilizzare l'apprendimento per rinforzo inverso offline per generare prompt dipendenti dalla query.

- OPRO (opens in a new tab) - introduce l'idea di utilizzare gli LLM per ottimizzare i prompt: lasciare che gli LLM "Facciano un respiro profondo" migliora le prestazioni sui problemi matematici.

- AutoPrompt (opens in a new tab) - propone un approccio per la creazione automatica di suggerimenti per una serie di compiti diversi, basato sulla ricerca guidata dal gradiente.

- Prefix Tuning (opens in a new tab) - un'alternativa leggera alla sintonizzazione fine che aggiunge un prefisso continuo addestrabile per i compiti NLG.

- Prompt Tuning (opens in a new tab) - propone un meccanismo per l'apprendimento di suggerimenti morbidi attraverso la retropropagazione.