Mistral Large

Mistral AI veröffentlicht Mistral, ihr fortschrittlichstes großes Sprachmodell (LLM) mit starken Fähigkeiten in mehreren Sprachen, im logischen Denken, in Mathematik sowie in der Code-Generierung. Mistral Large ist über die Mistral-Plattform namens la Plataforme und Microsoft Azure verfügbar. Es ist auch zum Testen in ihrer neuen Chat-App, le Chat (opens in a new tab), verfügbar.

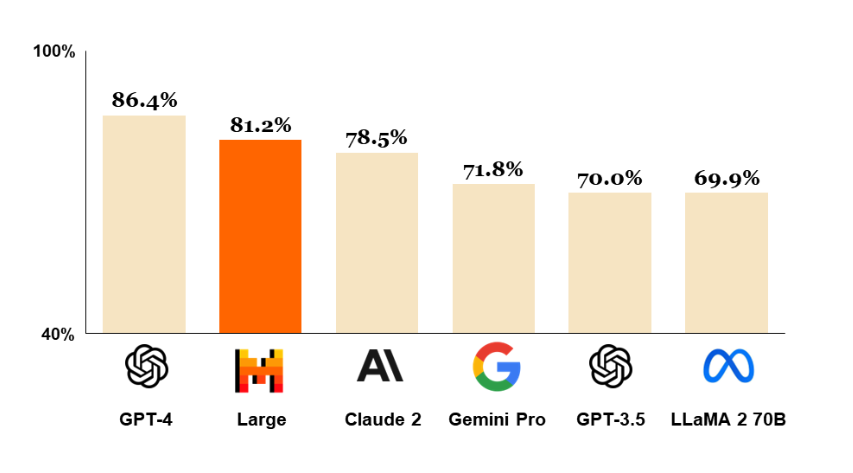

Unten ist ein Diagramm, das zeigt, wie sich Mistral Large im Vergleich zu anderen leistungsfähigen LLMs wie GPT-4 und Gemini Pro schlägt. Es rangiert auf dem MMLU-Benchmark mit einer Punktzahl von 81,2 % an zweiter Stelle nach GPT-4.

Fähigkeiten von Mistral Large

Die Fähigkeiten und Stärken von Mistral Large umfassen:

- 32K Token Kontextfenster

- hat native mehrsprachige Kapazitäten (fließend in Englisch, Französisch, Spanisch, Deutsch und Italienisch)

- starke Fähigkeiten im logischen Denken, Wissen, in Mathematik und bei Programmier-Benchmarks

- Funktionenaufruf und JSON-Format werden nativ unterstützt

- ein Modell mit niedriger Latenz namens Mistral Small wurde ebenfalls veröffentlicht

- ermöglicht Entwicklern, Moderationsrichtlinien mit seiner präzisen Anweisungsbefolgung zu gestalten

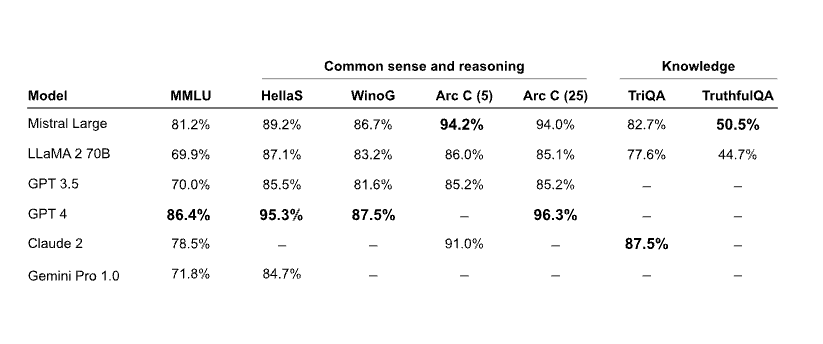

Logik und Wissen

Die untenstehende Tabelle zeigt, wie sich Mistral Large in gängigen Benchmarks für logisches Denken und Wissen schlägt. Es bleibt weitgehend hinter GPT-4 zurück, ist aber das überlegene Modell im Vergleich zu anderen LLMs wie Claude 2 und Gemini Pro 1.0.

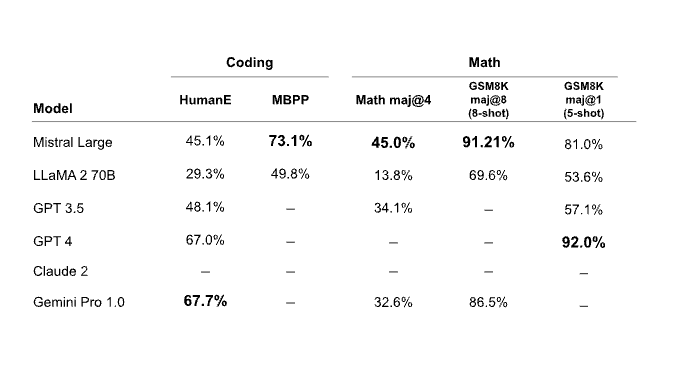

Mathematik & Code-Generierung

Die untenstehende Tabelle zeigt, wie sich Mistral Large in gängigen Mathematik- und Programmier-Benchmarks schlägt. Mistral Large zeigt starke Leistungen bei den Mathematik- und GSM8K-Benchmarks, wird aber bei Programmier-Benchmarks von Modellen wie Gemini Pro und GPT-4 deutlich übertroffen.

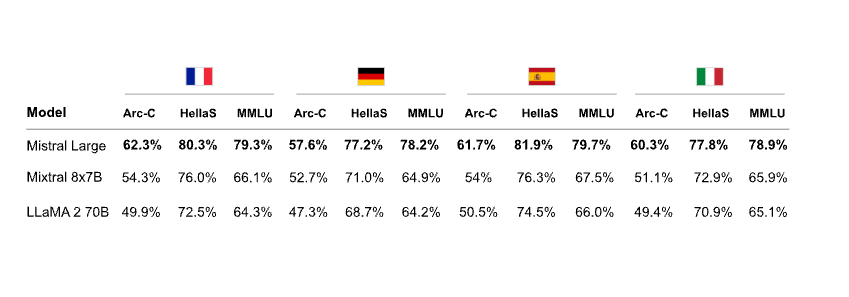

Mehrsprachigkeit

Die untenstehende Tabelle zeigt die Leistung von Mistral Large bei mehrsprachigen logischen Benchmarks. Mistral Large übertrifft Mixtral 8x7B und Llama 2 70B in allen Sprachen, einschließlich Französisch, Deutsch, Spanisch und Italienisch.

Mistral Small

Zusätzlich zur Veröffentlichung von Mistral Large wird auch ein kleineres und optimiertes Modell namens Mistral Small angekündigt. Mistral Small ist für Arbeitslasten mit niedriger Latenz optimiert und übertrifft Mixtral 8x7B. Mistral AI berichtet, dass dieses Modell starke Kapazitäten rund um die RAG-Aktivierung, Funktionenaufruf und JSON-Format hat.

Mistral Endpoints und Modellauswahl

Hier (opens in a new tab) finden Sie eine Liste aller von Mistral AI bereitgestellten Endpoints.

Mistral AI hat zudem einen umfassenden Leitfaden (opens in a new tab) zur besseren Modellauswahl unter Berücksichtigung von Leistung und Kosten veröffentlicht.

Quelle der Zahlen: https://mistral.ai/news/mistral-large/ (opens in a new tab)